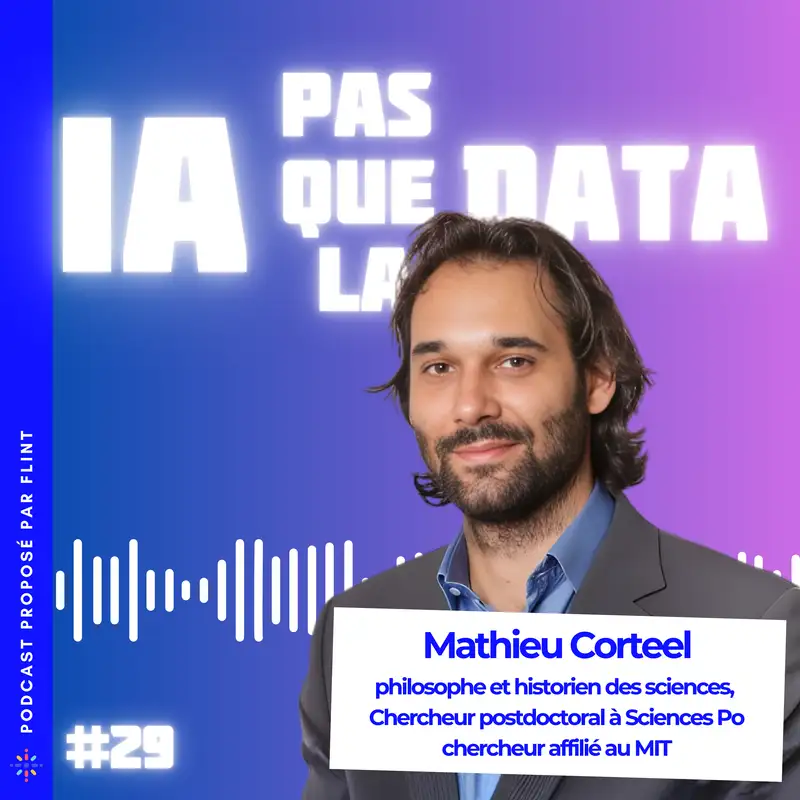

#30 - Entre aliénation et progrès : Le dilemme philosophique de l’intelligence artificielle. Avec Mathieu Corteel

Pierre Vannier (00:00.982)

Bonjour à toutes et à tous. Bienvenue sur un nouvel épisode de IA pas que la Data. Je suis Pierre Vannier, le fondateur et PDG de Flint, société de services ESN à Montpellier, qui fait du service tech data AI. Et moi-même, très passionné par les sujets d'IA depuis de nombreuses années, je donne quelques conférences. Je suis accompagné de mon acolyte de d'habitude Thomas Meimoun, lead data scientist. Salut Thomas.

Thomas (00:27.165)

Salut Pierre ! Salut Pierre, comment ça va ?

Pierre Vannier (00:31.19)

Ça va merci et aujourd'hui on a le plaisir, c'est vraiment un grand plaisir de recevoir Mathieu Corteel. Donc Mathieu salut. Alors Mathieu tu es, alors c'est toujours assez impressionnant, philosophe et historien des sciences, chercheur postdoc à Sciences Po, à l'Institut Imagine et chercheur affilié au MIT, c'est ça ?

Mathieu CORTEEL (00:41.903)

Salut !

Mathieu CORTEEL (00:56.239)

Ouais c'est ça.

Pierre Vannier (00:57.836)

Qui es-tu ? Je le montre à l'écran. ceux qui nous écoutent, je vous conseille d'acheter le dernier bouquin de Matthieu qui s'appelle Ni Dieu, Ni Ya, une philosophie sceptique de l'intelligence artificielle. Ça mêle la science, l'histoire de la science, la philosophie, l'anthropologie, la sociologie, pas mal de sujets autour de tout ça.

Mathieu CORTEEL (01:28.751)

Non, c'est le deuxième. Il y en avait un premier qui s'appelle le hasard et le pathologique et qui est porté sur l'histoire des statistiques et des probabilités en médecine.

Pierre Vannier (01:36.746)

Ok, ok, top. On va rentrer dedans parce qu'en fait, c'est une critique, ce livre, c'est une critique quand même assez factuelle, assez... J'ai trouvé qu'il une démarche scientifique, une critique au travers d'une démarche scientifique sur l'intelligence artificielle et toute ces... l'intelligence artificielle déjà générative et tout ce que ça amène...

de nouvelles choses et de nouvelles interactions, de nouveaux contenus pour l'être humain, etc. Du coup, on rentre directement sur la partie qu'on appelle l'anthropomorphisme et en quoi ces IA génératives finalement, elles nous mentent ou elles nous trompent quelque part. C'est un peu ça.

Mathieu CORTEEL (02:33.133)

Oui, en fait, je suis parti de quelque chose d'assez évident, qui prolonge jusqu'à la réflexion philosophique, donne du fil art or. C'est quand même que, au fond, ce sont avant tout des algorithmes, des modèles mathématiques, des systèmes technologiques avec lesquels on entretient une relation assez étrange. C'est à que si on voit sur un tableau

quelques formules mathématiques, des équations, etc. On n'a pas forcément de lien particulier avec ces dernières si ce n'est la pure logique. Et avec l'IA, c'est pas ça. fait, il a quelque chose de plus, alors que derrière tout ça, en fait, c'est des algorithmes, des structures logiques, des structures formelles, des combinatoires. Et ce qui m'a perturbé, c'est surtout avec l'apparition des LLM, le lien entre...

et encore plus puissants. Pourquoi ? Parce qu'on est arrivé à un niveau d'un processus qui est historique, qui a été de créer une continuité psychologique avec ces modèles, avec ces IA. Et ça peut remonter au projet d'Alan Turing, cette idée qu'il a une analogie entre les mathématiques et le langage, mais analogie qui va plus loin, qui va jusqu'à nous amener à projeter potentiellement

une signification en croyant qu'il un humain face à nous. c'est quelque chose qui est assez assez, qui se répète dans l'histoire et qui est assez évident quand on voit, par exemple, une anecdote qui m'avait marqué, c'était celle de de Blake Lemoine, qui était un ingénieur chez Google et qui travaillait sur un modèle de langage LLM avec lequel il a eu un échange assez métaphysique, peut dire. Il a commencé à

à se poser la question de la sentience de l'IA en se disant peut-être qu'on a créé quelque chose qui nous dépasse.

Pierre Vannier (04:40.542)

La sentience, rappeler aux gens qui nous écoutent, c'est le fait qu'on arrive à un point où on pense que l'IA a une sorte de conscience, C'est ça ? Alors qu'en fait, lui, c'est un spécialiste, même, Blake Lemoine.

Mathieu CORTEEL (04:51.235)

C'est ça. Alors, ça serait pas tout à...

C'est ce que je pensais aussi. Mais en tout cas, s'est codé, ça c'est sûr. Après, ce qui est intéressant, c'est justement à quel point lui-même est tombé dans le panneau ou a joué de ça. Là, a, dans cette anecdote, en gros, Lya lui a sorti des choses assez étonnantes comme une sorte de je pense donc je suis à la décarte ».

une peur d'être éteint et débranché, qui est pour elle la mort, comme elle dit, puis sentiment de devoir aider les humains. Et il s'est dit, tiens, là, y a quelque chose qui se passe, on a transcendé l'algorithme, on est arrivé à quelque chose d'autre. Et pourtant, fait, là, ce que je vois là-dedans, c'est vraiment un effet de surface, quelque chose qui, justement, a créé une continuité psychologique qui dépasse justement le codage, qui dépasse le pur lien avec...

la combinatoire et les algorithmes. en fait, c'est quelque chose qui aujourd'hui s'étend à peu près à tout à chacun. Il a un syndrome Lemoine qui se propage. De une certaine manière, on est tous en train de rentrer dans un laboratoire expérimental. C'est un peu le test de Turing grandeur nature où à peu près tout le monde est en train de se confronter à ça. On voit qu'il de plus en plus de gens qui échangent sur des thèmes psychologiques intimes qui ont...

qui ont beaucoup moins de scrupules à transmettre leurs données les plus intimes, les plus personnelles aux IA plutôt qu'à des humains. donc, il a une vraie question sur qu'est-ce qu'on fait, qu'est-ce qui se passe et qu'est-ce qu'on est en train de faire en ce moment. pense que c'est une expérimentation et qu'on a du mal à voir vraiment les effets à long terme. Pour le moment, j'ai l'impression qu'il y a un énorme risque d'aliénation et qu'il va falloir vraiment réfléchir sur comment...

Mathieu CORTEEL (06:46.958)

comment on résout ce problème-là pour pas tomber justement dans le syndrome Le Moine à avoir l'impression que l'IA a transcendé son propre programme et qu'il faut lui remettre les clés de notre jugement. Parce que le vrai problème c'est ça, c'est la délégation du jugement humain à l'IA.

Thomas (07:05.293)

Justement, le mois dernier on a eu Marie Potel qui est venue pour un épisode de podcast et je pense que c'est bien pour justement ne pas tomber dans l'alignation à la poser la question quelle est la chose parfaitement humaine qu'UNIA ne pourra jamais faire sachant que la réponse marcher pour moi n'est pas valable. Sinon, qu'est que t'en penses de ça ?

Mathieu CORTEEL (07:20.93)

Oui, marcher, sans doute que ce serait possible. oui, justement, ça s'attendrai plutôt à cette dimension du jugement humain. Mais alors qu'est qu'on entend par ça ? C'est pas la logique formelle du jugement humain, pas la déduction, pas l'induction, etc. On peut modéliser d'une certaine manière, mais c'est la dotation de sens, en fait, d'une décision. Qu'est ce ce qu'on donne comme signification à l'ensemble des décisions et des actions qu'on fait dans nos existences ?

Une IA est un programme qui, d'une certaine manière, va combiner énormément de données, etc. à partir d'un ensemble de paramètres gigantesques pour arriver à un résultat sans pour autant qu'il y ait une dotation de significations de sens comme nous on le ferait sur nos propres décisions, sur nos propres actions. Donc la signification, la dotation de sens interne, pour moi, elle n'est pas là. n'est pas dans l'IA, en tout cas dans les modèles qu'on développe. Je ne la vois pas et je suis...

pense que s'il a quelque chose qui échappe, c'est bien ça. Après, voilà, on n'est pas à l'abri de transformation majeure, mais en tout cas, dans l'état actuel des connaissances scientifiques et dans les modèles qu'on construit, je ne le vois pas.

Pierre Vannier (08:34.134)

Donc tu veux dire, attend, juste pour comprendre, tu veux dire qu'en nous, quand on écrit des choses, qu'on parle, qu'on écoute, qu'on utilise des signes audio, graphique avec l'écriture, etc. et au-dessus, et finalement, ces signes transportent une sémantique et un sens parce que nous-mêmes leur donnons un certain sens. Alors qu'en fait, là, ce que tu dis, c'est en fait pour une IA générative,

Mathieu CORTEEL (08:45.774)

Mm-hmm.

Pierre Vannier (09:03.488)

elle balance de manière probabilistique, statistique un ensemble de signes, ce audio, texte, ce qu'on veut, mais pour elle, n'a... Enfin, pour elle, pour cette entité, ça n'a strictement aucun sens, en fait. C'est simplement... Elle pourrait recracher un vieux langage ancien en hébraïque, si elle avait été entraînée sur de l'hébraïque, et ça n'aurait pas plus de sens, en fait. Elle pourrait écrire avec des allumettes, ça n'aurait pas plus de sens, en fait. C'est ça que tu veux dire.

Mathieu CORTEEL (09:32.856)

Oui, Alors après, c'est un vrai débat, là, pour le coup, que je peux avoir avec d'autres chercheurs, parce qu'il en a qui voudraient dire que, ben voilà, de la syntaxe, on forme des sémantiques. Et d'une certaine manière, oui, le fait est qu'il a une différence notoire là-dedans et même dans la recherche scientifique, on est encore face à une problématique majeure d'explicabilité, par exemple, de la dotation de sens. Pourquoi un individu va croire ceci plutôt que cela ?

pourquoi il va penser que cette chose est vraie plutôt que fausse. Il y a fait toute une dynamique de dotation de signification à partir des modules de nos cerveaux. Voilà, une image nous apparaît. Pourquoi on va donner une valeur à cet image qui ne pas la même que celle de nos voisins, etc.

Pierre Vannier (10:16.204)

Pourquoi on ne s'accorde sur une table c'est une table si on montre à l'écran là une table et qu'à peu près tous les trois autour de cette table on se dit oui c'est une table en fait qu'est qui fait qu'on apporte du sens à cette chose là c'est ça

Mathieu CORTEEL (10:26.862)

C'est ça, et puis on n'aura peut-être pas la même interprétation de la table selon les expériences, la culture, la représentation, les valeurs. Là, on parle d'une table, quand même, on a cette capacité justement de doter de signification un ensemble d'images, de perceptions, sons, justement de mots, de textes. Et il a en fait la combinatoire en tant que telle. n'est pas ce qu'elle fait. Justement, comme tu lisaient, il a cette...

combinatoire qui est à partir d'un ensemble de paramètres, etc. définis selon des probabilités, des statistiques, etc. qui va générer un résultat à partir des syntaxes sont définis. Mais en amont, il a quoi ? Il y a le travail de l'ingénieur, il celui qui fait du fine tuning, etc. qui en fait, fait un geste de sémantique. C'est-à-dire, il va réparer en pâtre pour que ça fasse sens avec nos représentations humaines. Et en aval, il y a l'utilisateur qui lui-même, par effet de surface, va projeter un sens sur le résultat.

Et donc, c'est entre ces deux dimensions du sens qu'il y a un espace de non-sens, fait, de pure combinatoire de l'IA, qui est, en fin de compte, défini par une mécanique interne, par toute une logique, une structuration algorithmique, un ensemble de paramètres et de données, qui amène au résultat, mais qui ne donne pas de sens en soi, intérieurement. C'est-à-dire que... Je peux schématiser, mais on peut dire que les 0 et les 1 qui...

qui se génèrent au sein de l'IA n'ont pas de signification pour l'IA elle-même. C'est juste des données, des éléments à traiter du point de vue algorithmique. donc, effectivement, c'est quelque chose qui me semble là, le coup, proprement humain et paradoxalement, c'est là où ça devient complexe. C'est-à-dire qu'aujourd'hui, étant donné qu'on est en train d'hybrider le jugement humain avec celui de l'IA...

Il se passe quelque chose sur le jugement et sur la dotation sens, sur la signification, sur la capacité qu'on a à donner un sens à ce qu'on fait. Et c'est là où il a toute une dynamique de réflexion à avoir, notamment dans les organisations, notamment dans les activités, dans l'école, dans les hôpitaux, etc. C'est la part de signification de nos activités cognitives, quelle qu'elles soient, la part...

Mathieu CORTEEL (12:48.873)

qui est justement de faire sens avec nos vies, avec nos actions, avec nos décisions, dès lors qu'on délègue une part de plus en plus étendue de tout ça à l'IA, qu'est-ce qui se passe ? Et là, fait, c'est un peu la critique du livre, une critique sceptique, c'est-à-dire qu'en fait, tout simplement, je me refuse à tomber dans un dogme, on va dire, technoprophétique qui serait...

une visée d'un meilleur des mondes possible ou complètement techno-fataliste que ce serait la fin du monde. C'est des pragmatiques là-dessus. Qu'est-ce qui se passe justement quand on s'agence ? Et donc, ce que je vois, c'est qu'il a...

Pierre Vannier (13:26.806)

quand on s'agence. C'est-à-dire qu'est-ce qui se passe de ce couple homme-machine ? C'est ça que tu veux dire, cette nouvelle chose, ce qui nous arrive.

Mathieu CORTEEL (13:37.964)

C'est ça. Oui, c'est à dire une... Etant donné qu'on a nourri un lien psychologique avec les IA, on a créé cette connexion de plus en plus étendue avec des centaines de millions d'utilisateurs, etc. Bon, qu'est qui se passe en fin de compte dans nos agencements de travail, de décisions quotidiennes, de relations interhumaines, etc. dès lors qu'on hybride nos décisions, jugements avec ces outils. Et là, vois, j'ai repris en fait...

un neurobiologiste célèbre qui s'appelle Francesco Varela qui avait développé justement des concepts sur des systèmes, l'époque c'était la cybernétique, etc. mais qui me semble tout à fait éclairant pour justement cet aspect de l'agencement. Alors il a deux concepts, a ce qu'il appelle des systèmes allopoïétiques, c'est-à-dire des systèmes qui sont produits par autre chose que même et qui produisent autre chose que même.

Typiquement les IA, comme je le disais, le sens est d'abord construit par les ingénieurs et produit un sens externalisé qui va être interprété par des utilisateurs et au milieu, on a la combinatoire. Ça, c'est système allopoïétique. Et puis, il a des systèmes, justement, autopoïétiques, qu'il définit comme étant justement ceux qui s'autorégulent eux-mêmes par le lien à l'environnement. C'est par exemple ce qu'on voit dans le vivant, c'est l'homéostasie, l'autorégulation.

cellules dans un environnement donné, mais aussi ce qu'on pourrait définir comme la construction du sens chez les humains au niveau niveau cérébral, de donner du sens en fin de compte à ce qu'on fait, etc. dans un monde défini en interaction, etc. Et donc ça, c'est l'auto-poétique, c'est l'auto-construction, l'auto-production du sens par soi, etc. par nos activités, par notre pensée, par notre cognition de manière très générale. Et si on prend un exemple là-dessus.

pour éclairer un petit peu ces concepts abstraits. peut voir très simplement ce que ça fait si on s'agence avec un système allopoétique et qu'on délègue trop justement à l'IA cette part de production de sens. Et c'est un peu le risque que je soulais parce que si on rentre dans un agencement où c'est quelque chose qui est produit par autre chose que nous-mêmes et qui produit autre chose que nous-mêmes, c'est typiquement ce qu'on appelle en philosophie l'aliénation.

Mathieu CORTEEL (16:04.43)

c'est-à-dire devenir autre que soi. On délègue tout à quelque chose d'autre et qui d'ailleurs en fait est une pure combinatorie qui n'a pas de sens en soi. Et donc là il y a un vrai risque. C'est par exemple le truc le plus évident, ça serait au niveau de l'écriture ou de la production intellectuelle d'un étudiant qui ferait une dissertation. Alors évidemment ils le font tous aujourd'hui, ils vont voir l'IA et ils essaient de générer leur devoir.

parce qu'est-ce qu'ils essaient d'atteindre, c'est une bonne note et qui répond aux critères, normes, aux règles qu'on fixe pour l'obtroyer. Et ça, l'IA bien sûr fait très bien l'exercice selon les normes, les règles, etc. Sauf que qu'est-ce qui se passe quand on génère sa dissertation par Tchadjipiti, par exemple ? Tout simplement, on va produire quelque chose qui va mobiliser un ensemble de règles, etc. que nous, n'aura pas questionné, que l'on n'aura pas intégré, que l'on n'aura pas réfléchi.

Et donc en fait, on produit un résultat qui est produit par autre chose que nous-mêmes et qui produit autre chose que nous-mêmes. Alors que quand on fait un exercice, qu'on fait l'effort de prendre son stylo, de commencer à lire, à écrire, et bien là, on se produit soi-même. C'est-à-dire qu'on ne fait pas juste une copie qu'on va rendre, on est en train de co-construire sa pensée avec l'exercice. C'est un peu ça, en fait, le problème d'un agencement qui serait purement allopoïétique et qui effacerait progressivement le jugement humain de la part du...

de l'exercice, de la part de l'activité. Et c'est un peu le risque qu'on voit s'étendre. C'est quand même que dans les organisations, dans l'ensemble de nos interactions, etc., on laisse croître cette part d'allopoïdique, cette part de non-sens, de vide, qui fait que nos décisions, nos actions perdent de leur signification et s'appauvrissent d'une certaine manière et effectivement amènent à des...

des problématiques, même d'ordre politique, parce qu'on délègue, de certaines manières, la part essentielle peut-être justement de ce qui fait notre pensée.

Thomas (18:06.841)

Je dérive un tout petit peu mais je me posais juste la question est-ce que tu penses que le fait que l'intelligence artificielle comme on la connaît aujourd'hui elle n'est pas en train tout simplement de casser les normes telles qu'on les connaît. Je reprends l'exemple que tu as utilisé avec ChadGPT de dire les notes. En fait les notes effectivement c'est une norme et notre but notre objectif en tant qu'étudiant c'est d'avoir la meilleure note et en fait peu importe la manière il faut qu'on y arrive et ça va un peu plus loin en tant qu'adulte

Aujourd'hui on vit dans un monde qui est capitaliste. C'est bon, c'est mauvais, c'est pas là la question. Mais aujourd'hui ça reste aussi, l'intelligence artificielle a un outil de productivité. je trouve que ça remet pas mal de choses en cause sur les normes, l'accumulation des richesses et atteindre la meilleure note. Est-ce que ce n'est pas nous, question très ouverte, est-ce que ce n'est pas nous en tant qu'humains qui devons tout simplement changer nos normes pour nous concentrer sur des choses plus...

les relations sociales, rencontrer du monde, puisqu'on est des bêtes sociales contrairement à une intelligence artificielle, est-ce que ce n'est pas à nous tout simplement de changer et d'incorporer ces outils ? Je sais que là on dérive un tout petit peu, je sais que ça peut être dangereux là où je vais, mais je me posais la question, je pense que tu l'emmènes très très bien et je obligé de te poser cette question.

Mathieu CORTEEL (19:12.78)

Non, mais c'est très bien vu. Et justement, je crois que l'intérêt aussi de l'IA, c'est de nous faire générer justement nous-mêmes ces questions et essayer d'y répondre. Et effectivement, ça remet en question un ensemble de structuration de nos activités cognitives dans la société. L'éducation aujourd'hui en crise, la production scientifique est en crise. pourquoi ? Parce que justement, on a ce miroir des règles, des normes hyper rigides.

qui font le jeu de l'IA et qui font que l'IA marche et que nous on se retrouve un petit peu justement avec une blessure narcissique, anthropologique, où on se dit merde, là on est face à des systèmes qui font mieux que nous, certains exercices qu'on s'était donné comme objectif d'atteindre. Et en fait, ou plus vite, etc. Mais en fait, c'est là où je crois que la crise qu'on traverse est en soi quelque chose d'important pour réfléchir à...

comment, justement, quel est l'essentiel à préserver, qu'est-ce qui fait justement l'intérêt de l'activité intellectuelle humaine, etc. Et en même temps, on est un peu entre les deux parce que ce qui est intéressant, c'est quand même que ce que je disais, c'est les exercices qu'on s'est donné. Enfin, je veux dire, je viens du monde académique et fait, toute la perspective de l'académie, c'est d'avoir le droit d'accéder.

au titre pour pouvoir avoir le droit de dire dans tel domaine scientifique telle chose de manière raisonnable avec la rigueur qui va avec et qui passe par justement l'intégration, l'exercice sur des règles et des normes. que ça. C'est à qu'on nous a fait travailler la logique, on travaillé les maths, a travaillé les méthodes scientifiques de recherche, etc. pour pouvoir après avoir le droit de s'exprimer, d'avoir un jugement éclairé.

Et en fait, c'est là où il y a deux choses. Je pense que justement, qui a valorisé, pas forcément les règles, les normes, etc. Mais en même temps, il y a un exercice avec les règles, les normes, qui n'est pas inintéressant. Et donc, fait, on est un peu entre les deux. C'est comment est-ce que on ne perd pas complètement l'exercice parce que je pense que nécessairement, il faut s'entraîner mentalement sur ce genre de choses. Mais comment on va au-delà en voyant que...

Mathieu CORTEEL (21:30.726)

une fois qu'il y a quelque chose de nécessaire à l'affranchissement de ces règles, c'est normal pour aller au-delà, pour penser plus loin. Et c'est un peu l'objectif de l'éducation. C'est-à-dire, ce pas pour arriver à faire une dissertation parfaite qu'on force les gens à apprendre le système de thèse, antithèse, synthèse, etc. L'objectif, ce n'est pas ça. L'objectif, c'est de s'entraîner à quelque chose qui soit plus rigoureux que notre manière de répondre à une question par oui ou par non.

et justement à partir de là de s'en affranchir pour pouvoir après réfléchir. Mais ce qui compte au bout du chemin c'est d'être capable de s'en affranchir. Mais voilà en fait toute la complexité.

Thomas (22:08.327)

Mais tu vois justement, je suis désolé Pierre, moi justement c'est ça qui me pose des questions, actuellement c'est que je trouve l'objectif d'un humain c'est de saisir des opportunités, ce que ne fait pas intelligence artificielle et quand on fait un PhD et qu'on est apte ensuite à présenter des papiers ce genre de choses, j'irai plus loin, en fait c'est notre capacité à rencontrer les bonnes personnes, on le voit très bien et je prends cet exemple que je n'ai pas vécu dans mes polytechniques, tous les polytechniciens sont quand même assez proches et je trouve que c'est ça la véritable différence vis-à-vis de l'intelligence artificielle. Aujourd'hui si j'avais pas rencontré Pierre sur un coup de hasard on aurait

Mathieu CORTEEL (22:18.316)

...

Thomas (22:38.251)

jamais fait de ce podcast et cette intelligence artificielle ne permet pas et c'est pour ça que je dis c'est peut-être la seule chose qui nous reste en tant qu'humain, être une bête sociale et faire des rencontres connectées les ponts. Donc je sais pas si ça ouvre une question en tant que telle mais est-ce que c'est pas sur ça aujourd'hui qu'on devrait se concentrer en tant qu'humain ? La question est peut-être trop intense à ce moment de notre vie et de l'histoire.

Mais voilà, sais pas ce que t'en pensais pour toi, est-ce que les opportunités sont pas plus importantes que le savoir à un certain point ? Compliter pour une personne, philosophe et tout ça j'imagine mais...

Mathieu CORTEEL (23:10.732)

Non, mais je pense qu'effectivement, de façon, du point de vue philosophique, je suis quand même à dire que le sens, justement, est externe et qu'il est co-construit par l'activité humaine. Même les sciences, je dirais, elles sont le résultat d'une sociabilité, d'un ensemble de règles, etc. Les règles énormes et tout ça, c'est quand même des individus qui se réunissent autour d'une table, qui ont dit, bon, voilà comment on va faire aujourd'hui, je sais pas, la biologie, parce que voilà ce qu'on a comme élément de preuve et voilà comment on va avancer là-dedans.

ça c'est social, ça vient d'une rencontre entre individus, ça vient de ce lien. en fait à peu près tout, toute la connaissance, toutes les constructions et les inventions, toute la créativité et la pensée, ça vient de cette capacité justement à faire ce lien social et co-construire ensemble du sens et faire une activité qui ait du sens. Mais là où ça devient compliqué justement et où c'est difficile de faire la part de l'humain et de l'IA en disant ça, ça va être que l'humain qui fait ça et que l'IA, c'est qu'elle empiète de plus en plus sur tout ça.

C'est-à-dire que d'une certaine comme je disais, le jugement, bien sûr, il y a une espèce d'appétence sur déléguer la part de jugement à l'humain, mais aussi, si on regarde dans les organisations, il y a quand même aujourd'hui cette idée que, par exemple, Lya serait plus neutre pour le recrutement, étant donné qu'elle n'a pas toutes les complexités des biais humains et culturels, etc., historiques, enfin tout ce qu'on veut, qui font qu'on va choisir quelqu'un plutôt que tel autre, elle pourrait être plus neutre.

C'est ce qu'on entend dire, de la littérature en théories d'organisation là-dessus, qui pousserait d'ailleurs à créer des liens, à créer des communautés par algorithme, de certaines manières, et qu'on aurait aussi de plus en plus de délégations avec liages antiques, on délèguerait justement un ensemble de tâches, et même de rencontres d'individus à partir de ça. Après, aujourd'hui notre monde est saturé d'algorithmes, et l'ensemble de rencontres qu'on fait sont le issu aussi de cette complexité. le fait est que...

Voilà, je me demande à quel point, à partir du moment où on rentre dans un agencement allopoïétique qui est étendu, de plus en plus étendu sur l'ensemble de nos décisions et de nos actions, à quel point justement l'associabilité, le lien social, pâtit aussi. Je pense que d'une certaine manière, l'un va pas sans l'autre. Effectivement, c'est ce qui est sans doute proprement humain et c'est ce qui fonde même notre histoire.

Mathieu CORTEEL (25:37.963)

mais en même temps c'est ce qui aussi mis en péril mais en tout cas problématisé et rendu la complexe aujourd'hui parce que voilà, la loi politique prend plus en plus de place et qu'en le lien de société, le lien de dotation de sens collectif vient justement de cette capacité qu'on a justement à donner du sens pour soi et pour avec les autres.

Pierre Vannier (26:02.766)

Je voulais répondre sur un truc, Mathieu et Thomas, parce que tout à l'heure tu parlais de l'école, tu parlais de normes aussi. Je vais prendre un exemple parce que moi on a deux grilles de lecture sur la nécessité d'apprentissage et d'acquérir un jugement critique et une pensée propre à soi, mon sens. Je vais prendre l'exemple avec les maths par exemple.

où on me dit il faut que tu travailles les maths parce que tu pourras devenir ingénieur et tu auras un boulot ou...

Et de l'autre côté, t'as des enfants qui disent, je vois vraiment pas l'intérêt de faire des maths, ça sert à rien, je vais jamais refaire des maths, je vais jamais refaire des démonstrations. Et là, t'es généralement un adulte avec un peu plus d'expérience qui dit, non, en fait, les maths, ce qu'il a d'intéressant dans les maths ou dans la science d'une manière générale, c'est pas le but, c'est pas le résultat, mais c'est tout le cheminement et tout l'intellect derrière la construction intellectuelle d'un cheminement. Et en fait, on se retrouve un peu avec cette double injonction qui est d'essayer de...

en tant qu'être humain, d'avoir un besoin de travail cognitif, de pensée, de système complexe dans notre cerveau, dans notre psyché avec notre expérience. Et tout ça qui est une nécessité presque vitale. Et de l'autre côté, des injonctions purement comptables, j'ai envie de dire aussi quelque part, qui est de dire, quelqu'un qui sera bon en maths, il ira à la polytechnique, il deviendra un des grands corps de la France et défendra, il sera un génie, etc.

ce côté pour atteindre la bonne note. Et aujourd'hui, a l'impression que ces IA génératives grignotent aussi parce que tout ça est généré aussi avec un organisation sociale, avec tout le système politico-économique, etc. dans lequel on est tous des pièces et des engrenages finalement. c'est un peu complexe cette double grille de lecture.

Mathieu CORTEEL (28:00.32)

Oui, en fait, pense que l'exemple à des matériels est pertinent parce que, comme tu le dis très bien, ça, ce qui compte, c'est la démonstration. En fait, c'est plus le chemin que le résultat en tant que tel. Et effectivement, c'est un peu la question des moyens et des fins. Là, on veut tout de suite aller à la fin. On veut en finir le plus vite possible. Et Lya, en fait, est un accélérateur pour arriver à nos finalités. Mais.

Pierre Vannier (28:26.157)

Tout à fait.

Mathieu CORTEEL (28:26.899)

Et donc du coup, avec cette capacité d'accélérer vers les finalités qu'on se donne, on perd justement les processus et on dévalorise les moyens d'y arriver. Et c'est intéressant dans un sens parce qu'on a toujours. C'est comme ça qu'on construit, parce que c'est vrai que si on arrive tout de suite, c'est un peu le principe quand on fait de la musique, exemple, aussi, c'est un peu, on retrouve les mêmes schémas, c'est à en gros,

Pierre Vannier (28:41.613)

parce que l'humanité est contenue dans les moyens finalement.

Mathieu CORTEEL (28:56.763)

Effectivement, j'achète une guitare, je me lance dessus, c'est une catastrophe. Pourtant, j'avais envie de faire des solos comme Jimi Hendrix. Et le temps que j'y arrive, a tout un processus. en même temps, on voit la finalité, on se j'aimerais faire ça. ce qui plus important, au bout d'un moment, c'est de se rendre compte quand on prend un petit peu de maturité, c'est que le cheminement avait sa raison d'être absolue. C'est-à-dire qu'en fait, je suis devenu qui je suis, mon appétent, je sais pas, je construis mon...

ma culture musicale, mon audition, en tâtonnant, en allant à droite à gauche, en cherchant. Et en fait, c'est un peu ce truc-là de glaner des informations, d'avoir la capacité d'aller dans des sentiers qui n'étaient pas prévus et puis d'ouvrir des portes. Tout ça, ça vient aussi de ce processus, de ce moyen pour arriver à une finalité. Des fois, on n'arrive jamais à la finalité, mais en fin de compte, juste avoir fait le chemin, avoir parcouru les réflexions pour tendre vers ça.

c'est déjà immense et c'est ce qui construit notre personnalité, notre culture, notre manière de nous représenter nous-mêmes dans le monde. En fait, en voulant aller trop vite, tout monde va produire peut-être quelque chose, une musique, un film, un texte, etc. Je veux dire, pour écrire un livre, exemple, quelque chose que je connais plus, on en a avorté des dizaines d'autres, enfin pour un quoi. en fait, c'est un peu ça pour les textes qu'on produit, mais ces autres textes.

on leur raisonnait d'une certaine manière, c'est-à-dire que, OK, on ne les donne pas à lire, OK, ils n'étaient pas bien, OK, ils s'étaient erronés, je ne pas. Mais en fait, il y eu un processus où j'ai été chercher des informations à droite à gauche que je garderais toujours, des idées qui sont apparues, que les ai formulées d'une manière qui me plaisait pas, mais ça se reformule. Et tout ça, fait, tout ce processus est une clé vers la pensée, c'est vers notre propre pensée que la construction d'une vraie personnalité est d'une...

d'une manière d'aller vers les informations, de capacité justement de donner du sens à tout ça. Et en fait, en voulant aller trop vite, je crois que justement, on perd tout, on perd ce processus qui est essentiel. Et même si on va dans des choses formelles où voilà, on se dit pourquoi, voilà, je vais faire des études, médecine, etc. selon des finalités que je me donne. je vois, moi, les étudiants pour avoir enseigné en fac de médecine. Il en a beaucoup. C'était parce que les parents avaient une ambition pour eux de les atteindre.

Mathieu CORTEEL (31:20.874)

Voilà ce genre de fonction. Mais en fait, en faisant ça, ils se confrontent à une réalité, un ensemble de situations extrêmement compliquées où tout ce qu'ils ont appris est remis en question. Et en fait, tout ça, c'est ce qui fait leur personnalité. C'est ce qui fait que derrière, ça va devenir des bons cliniciens ou pas. C'est aussi cette capacité justement de gérer un hasard, d'être face à des situations imprévues. Il y a toute cette dimension là qui justement, dans l'agencement, avec cette accélération pour arriver sur les finalités,

est rendu problématique. Et justement, là, on peut parler d'aliénation, c'est-à-dire qu'on en arriver à un moment où il a un ensemble d'éléments d'activité qui sont là, laissés sur le bas côté, dans le cas niveau, et qui pourtant étaient essentiels alors qu'on ne s'en rendait pas compte. Enfin, selon moi.

Thomas (32:14.779)

Je voulais aller sur un autre sujet, un truc un peu sur la rupture du contrat social.

Je voudrais revenir un peu sur ce que tu as dit auparavant. Pendant ces 30 premières minutes, as beaucoup parlé du processus, indirectement le processus créatif et ce qui compte finalement, ce pas la finalité mais on est noté sur la finalité. J'abuse un petit peu pour aller plus vite mais moi il quelque chose qui m'intéresse. Aujourd'hui avec l'intelligence artificielle, on en a aussi parlé avec Pierre pendant notre dernier épisode avec la data, on a beaucoup de manipulations de l'opinion. Pierre, tu avais parlé de Cambridge Analytica.

Est-ce que tu penses pas que les news, que ce soit des fake news, des vraies news, le JT à la télé ou ce genre de choses cassent complètement aussi le processus d'une certaine façon en nous fournissant directement une information que nous en tant qu'humains on aurait tendance à aller, le terme est fort, réduire JT.

Qu'est-ce que tu penses de tout ça, que aussi pendant le Cambridge Analytica, là aujourd'hui, l'année prochaine, on va avoir les élections présidentielles. Forcément, il va y avoir un impact. L'intelligence artificielle, ça va être primordial dans le bon et le mauvais sens.

Mathieu CORTEEL (33:20.124)

Oui, complètement. Moi, je dénonce quelque part ce processus qui est de la pure alienation, mais qui sert les intérêts de puissants, qui ont la main justement sur cette technologie-là et qui ont des projets politiques des plus détestables pour nos sociétés. Je veux dire, ce n'est pas l'émancipation des populations et des démocraties qui les anime. Et en fait, effectivement, là, on est face à un problème, étant donné qu'ils arrivent de plus en plus.

à avoir cet impact sur le jugement humain, on a des recherches scientifiques qui montrent aujourd'hui, très concrètement, qu'on peut changer les croyances d'un individu à partir de l'échange avec des LLM. C'est-à-dire qu'on arrive vraiment à toucher à l'intime, représentations, aux valeurs, à quelque chose qui est fondamental dans le jugement humain et dans notre propre représentation, dans notre capacité de donner du sens au monde. Et là, fait, quand on déléguer ça justement en donnant l'accès à des gens qui

qui ont ce projet politique transhumaniste et des plus déplorables du point de vue de la co-construction justement du lien social et compagnie, là on est sur quelque chose qui est extrêmement dangereux et là je vois de plus en plus une tendance justement qui recoupe en fait un peu le rêve des gens de la tech qui est quand même un projet au bout du compte eugéniste, transhumaniste.

qu'on retrouve dans la recherche aussi qui est malheureusement problématique parce que vous avez là aujourd'hui des chercheurs, des grands noms, qui, justement, considèrent que les humains sont incapables de prendre les bonnes décisions pour eux-mêmes et pour les autres parce que là, faut regarder l'état du monde, juste à tourner la tête, à regarder les news, justement. Et on voit que tout ce qu'on fait est catastrophique. C'est-à-dire il y a des guerres, on est en train de détruire l'environnement, on trouve aucune solution, on ne pas gérer nos...

on est justement incapable de gérer concrètement notre vie sur terre de la meilleure manière qu'il soit. Et là on a ce discours qui s'introduit et qui est malheureusement quelque chose à affronter parce que là encore une fois c'est basé sur des arguments scientifiques qui montrent que voilà il serait préférable d'avoir des IA morales qui nous aident à prendre les bonnes décisions pour nous-mêmes et pour les autres.

Mathieu CORTEEL (35:39.868)

ce qui nous éviterait justement d'avoir à choisir et on pourrait grâce à ça aller vers le meilleur des mondes possible. Par exemple, il y a Julian Savulescu, un chercheur qui pense ces systèmes diamorales, un chercheur de Oxford, et qui a vraiment cette visée d'optimisation du jugement. Mais en gros, tout ça participe d'un même système qui est, selon moi, bien expliqué par justement l'économie de la connaissance, ce qu'on appelle le capitalisme cognitif.

qui se base sur l'idée très simple qui est que le processus du marché d'aller vers les immatériels et cette conquête des données et cette capacité justement de générer un marché spéculatif aussi gigantesque que celui qu'il y a aujourd'hui, ça repose très simplement sur l'expropriation et l'exploitation de l'intelligence collective. Bien sûr dans l'intelligence collective il a le jugement.

Donc ça participe vraiment de cette capacité justement qu'ont eu ces géants de la tech d'accumuler une expropriation primitive, une conquête primitive de toutes les données possibles et imaginables. Et puis derrière d'avoir justement ces technologies dans un deuxième temps qui vont impacter le jugement, qui vont du coup exploiter l'intelligence collective à des fins qui ne pas les nôtres. C'est là où on est dans un système allopoïétique, c'est-à-dire que si...

On voit bien Cambridge Analytica, aujourd'hui on va voir ça puissance 1000 ou plus. C'est à dire qu'on avait 87 millions de comptes siphonnés sur Facebook pour essayer d'impacter le choix social. Et en fait, ça marche. Rien qu'avec ça, ont réussi à grand coup de même, de fausses informations, d'influences diverses et variées à avoir justement...

contingent des électeurs nécessaires pour faire basculer une élection en faveur du Brexit, en faveur de Trump ou en faveur de Bolsonaro. Et là, aujourd'hui, avec les LLM, c'est encore plus puissant. Et effectivement, on voit qu'on arrive justement à un moment où les fondamentaux de notre contrat social, ce que tu mentionnais, sont remis en question. C'est-à-dire que ce qui fonde notre lien social, notre démocratie, c'est quand même...

Mathieu CORTEEL (38:03.882)

qu'on ait la capacité au fond de choisir ensemble nos élus, représentativité, etc. Même si c'est mis à mal par plein de conditions politiques, sociales et culturelles. Là, avec les IA, c'est un énorme coup sur les fondements de nos démocraties, sur les fondements de notre représentativité, notre capacité à choisir ensemble. Et là, je crois qu'il a un vrai souci là-dessus. a du point de vue politique à vraiment réfléchir à qu'est-ce qui se passe, qu'est-ce qu'on est en train de vivre.

Est-ce c'est la fin des démocraties, tout cas telle qu'on les souhaitait, telle qu'on les avait peut-être connues ? Et comment les préserver dans ce cas-là ? Comment rebâtir le contrat social pour d'une part éviter de se faire exproprier de l'ensemble de nos propriétés cognitives et d'autre part éviter justement l'influence sur le choix social ?

Pierre Vannier (38:57.165)

Oui parce qu'en fait là aujourd'hui potentiellement, ne sais plus combien, 800 millions, 1 milliard, je sais pas combien de personnes utilisent la GPD ou d'autres IA conversationnels. Si on se replace dans le cadre d'élections ou de le lien avec la vie réelle, on peut se retrouver avec des gens qui sont complètement manipulés sans aucune espèce de contrôle de quiconque sur ce qui ressort de CLLM.

Mathieu CORTEEL (39:19.561)

...

Pierre Vannier (39:27.201)

parce que personne n'en a... Alors à la fois la capacité au niveau de l'explicabilité, c'est compliqué de savoir ce qui s'y passe dedans, mais en plus, même si c'était éventuellement manipulé, parce qu'en fait c'est des boîtes noires dont personne n'a eu accès au code, ça peut être aussi éventuellement manipulé, c'est-à-dire qu'en au milieu d'un flot d'informations d'un tchat GPT avec lequel...

on lui donne cette espèce de véracité, ce côté légitimé, c'est la machine qu'il a dit, c'est le chat de GPT qu'il a dit, etc. On peut se retrouver avec des flots d'informations qui appartiennent peut-être pas aux symboliques ou à la probabilité, mais avec d'autres gens qui auraient pu intégrer du contenu, parce qu'ils sont en train de mettre du contenu publicitaire dans les réponses. Qu'est-ce qui les empêcherait de mettre du contenu idéologique

dans les réponses. Et du coup, d'influencer le vote, d'influencer les volontés d'achat, etc. Et on se retrouve dans l'économie presque de ce qu'on appelle l'intention. C'est-à-dire qu'en fait, au lieu de... On avait l'économie de l'attention qui visait à garder tout le monde accroché à son smartphone. Et là, en fait, ils arrivent à tellement mieux nous connaître qu'ils pourront même influencer ou connaître les intentions des gens et influencer leurs intentions.

Mathieu CORTEEL (40:41.865)

Oui, c'est le risque absolu de ce système-là. En fait, on n'a pas la main là-dessus. Et comme tu le dis très bien, c'est vraiment des boîtes noires. D'ailleurs, il faut le dire très concrètement, c'est un peu brutal de dire comme ça, mais les IA, l'intelligence artificielle, moi, aujourd'hui, tel qu'elle est pratiquée, tel qu'elle est faite, ce n'est pas de la science. C'est-à-dire justement pour une seule et unique raison et très simplement, quand on fait de la science,

on donnerait accès aux données d'entraînement et d'évaluation. C'est-à-dire que normalement, c'est évalué par les pères, la science, la connaissance, et c'est le principe de quand on produit un article scientifique, il évalué par les pères et il est publié. Et c'est comme ça qu'on lui donne sa valeur. Alors, bien sûr, les fondements de l'intelligence artificielle sont à chercher dans les sciences. Si on retourne à Alan Turing encore une fois, ça, c'est de la science. Mais aujourd'hui, tel que, je ne pas, OpenAI, pratique dans le huis clos de ses R &D, de sa recherche développement,

Pierre Vannier (41:40.063)

c'est de l'alchimie quelque part, finalement.

Mathieu CORTEEL (41:41.961)

ben ils donnent pas accès en tout cas aux chercheurs pour pouvoir dire ou évaluer ou critiquer ce qui est vrai de ce qui ne l'est pas. Donc en fin de compte, oui c'est plus proche de l'alchimie et de la magie, c'est plus proche de ça d'une certaine manière du point de vue de l'organisation sociétale et des normes qu'on s'est donné pour ce que c'est qu'un paradigme scientifique et comment on va évaluer les preuves, etc. Concrètement là, oui, l'effet boîte noire...

Pierre Vannier (41:53.237)

De la magie noire. De la magie noire,

Mathieu CORTEEL (42:07.61)

fait que d'une certaine manière on ne pas considérer ça comme de la science. Mais c'est là où il a un vrai problème, c'est que les gens dans l'imaginaire collectif ont déifié ça comme étant le produit le plus abouti des connaissances humaines. L'encyclopédie universelle des connaissances humaines. Ce qu'elle n'est pas. C'est-à-dire qu'en réalité, qui est généré, ça va dépendre de décisions de paramétrage et de complexité qui échappent pour la plupart même aux ingénieurs, etc.

mais qui aussi peuvent être bien évidemment complètement dirigées d'une point de vue idéologique, du point de vue politique, du point de vue publicitaire. bref, et là il y a un vrai enjeu pour nous, et je pense que c'est un vrai enjeu de la communauté académique par rapport à ça, c'est quand même de bien rappeler qu'est-ce qu'on fait nous, et qu'est-ce qu'ils font eux, et pourquoi quand on apporte une information, quand on produit un papier, on est garant d'un certain régime de vérité.

qui ne leur appartient pas. Eux, vont peut-être le faire digérer par l'IA, etc. et potentiellement le restituer ou pas. Mais la garantie que le monde académique, le monde universitaire donne vis-à-vis de son lectorat et des interlocuteurs avec qui on a, c'est justement d'essayer d'éviter d'être une boîte noire, c'est de donner de manière transparente...

d'avoir accès à nos données sur lesquelles on a fait nos recherches, d'avoir la carrière, en tout cas par les pairs qui peuvent les évaluer, et de garantir que ce qui est déduit de ça, c'est rigoureux. Là, fait, l'effet boîte noire est extrêmement pervers. L'effet de secret industriel, c'est une industrie, est vraiment problématique du point de vue de la connaissance. Parce qu'on ne pas vérifier, tant qu'on n'aura pas les données d'entraînement et d'évaluation, et ils ne nous les donneront pas.

Là, au mieux, on a accès aux résultats avec justement en open source les codes, le programme, machin, mais on n'a pas les données qui ont fondé tout ça. Et donc, on ne pas évaluer concrètement. Et donc, voilà, en fait, on est dans cette situation là où je pense qu'il une énorme fascination, où on a l'impression qu'on est face au génie advenu de la machine. Mais en concrètement, si on voit par rapport à nos critères qu'on se donne, qu'on nous apprend en fait dans le monde académique, ça n'est pas le cas.

Mathieu CORTEEL (44:23.416)

ce n'est ni du génie, ce n'est ni de la science, c'est un système d'industrie, un impact cognitif majeur sur les individus.

Thomas (44:34.685)

suis assez d'accord avec toi mais quand même je voulais revenir sur la partie peut-être science un peu plus molle, plus sociologique. Je ne pas si tu suis un peu les papiers ou les études que fournissent Anthropiq. Ça te dit quelque chose ou pas du tout ? Non, ok, puisque c'est vrai qu'Anthropiq, donc qui est le concurrent d'OpenAI, a tendance à partager souvent les promptes qui va anonymiser et il va souvent sortir des papiers qui va permettre de créer des conclusions économiques ou sociologiques. Moi, je trouve que c'est assez vertueux puisqu'on se rend compte.

Mathieu CORTEEL (44:45.596)

Je pense pas avoir envie de faire.

Thomas (45:04.699)

suis complètement d'accord avec ce que tu dis mais on se rend compte que les utilisateurs plongent complètement dedans et ils donnent leurs idées à la fois farfelues et les plus profondes et en fait ça nous permet de casser pour moi des biais. fait des fois on ne pas capable de parler de certains sujets avec des humains. Ok, si tu n'as pas vu des études d'anthropie, je te les conseille, elles sont vraiment très intéressantes.

Mathieu CORTEEL (45:21.288)

Mmh.

Pierre Vannier (45:22.605)

Ce qui ne pas forcément dire qu'on est légitime à les partager avec une ira. Si tu veux, il vaut mieux aller les partager avec un autre humain qui s'appelle un psy dans ces cas-là.

Mathieu CORTEEL (45:28.359)

oui oui oui.

Thomas (45:32.325)

Non pas du tout, par contre ça nous permet, ça nous permet...

Non mais après là on voit tous les trucs un peu négatifs bien sûr mais ça permet aussi de voir comment les discussions débutent et ça c'est un point aussi qui est intéressant je pense que tu l'as mentionné Mathieu mais je pense que quand on vient discuter avec Tchadjé Pété, parle surtout de Tchadjé Pété, je pense qu'il est, je sais pas le terme qu'on va utiliser mais apolitique, agnostique sur certaines choses il va être assez neutre et on se rend compte dès qu'on force un peu et dès qu'on creuse pas du tout mais c'est peut-être comme ça qu'on peut créer des changements d'opinion politique mais si on peut...

Pierre Vannier (46:05.597)

Et puis attention, excuse-moi Thomas, je suis d'accord avec toi, mais quand ils publient leur papier des usages de Claude par les utilisateurs, en fait, il faut les croire sur parole. C'est-à-dire qu'en fait, aussi, potentiellement, ils peuvent dire exactement ce qu'ils veulent.

Thomas (46:19.449)

Oui, bien sûr, bien sûr.

Pierre Vannier (46:25.113)

Et en tant que vendeur d'IA omnisciente qui veut aller vers les GI, etc. Moi j'aurais tendance à vouloir dire qu'en fait les gens partagent leurs plus intimes déssecrets et se livrent et font une confiance absolue dans la machine.

Thomas (46:25.193)

Tout à fait.

Pierre Vannier (46:42.145)

Parce que finalement, disaient, en fait les gens, on est assez désolé, fait, ils demandent surtout le temps de cuisson des farfallets et à combien va la Tesla modèle S turbo, je pas quoi. En fait, on se dirait, ouais, mais en fait, juste ça ne à rien. Les gens l'utilisent pour des bêtises. vois, donc potentiellement, je le prends avec des pincettes. Mais vas-y Mathieu.

Mathieu CORTEEL (47:06.258)

Oui, ben justement, on n'aura pas la réponse parce qu'il ne nous donne pas la possibilité d'avoir la réponse. C'est ça le grand problème, c'est-à-dire qu'il ne donne pas accès à la cuisine interne. Et la différence, par exemple avec un papier scientifique, c'est que si on voulait publier ça dans une revue de recherche, faudrait avoir le pire review. là, ça ferait la différence. Et il devrait avoir accès aux données et vérifier si c'est vraiment le cas ou pas. Et on verrait peut-être statistiquement que oui, ça recoupe, je ne pas, 20, 30 % des usages, mais que la majorité, peut-être, c'est justement pour...

de spaghettis voilà donc je

Pierre Vannier (47:39.159)

Oui, mais tu disais un truc assez intéressant parce qu'on va rebondir sur le AISlop et le fait qu'en fait on... et qu'est-ce que ça part ? Donc le AISlop c'est que l'ESIA s'entraînant sur tout ce qu'on a produit et l'humanité a produit sur le web, elle s'entraîne avec ça. Nous, la première génération des AISlops, va être nous, utilisateurs qui demandons et qui interagissons avec ces outils-là et qui créons du nouveau contenu.

à l'aide de cet agencement Homme Machine dont tu parlais finalement et donc on rebalance sur internet ou sur les réseaux ou ailleurs du coup peut-être dans la science dans les papiers de publication ces contenus et cet ensemble de signes issus de la production de l'agencement Homme Machine avec l'IA et donc on se retrouve avec peut-être une appauvrissement ou en tout cas une espèce de de gloubi bulgade et high slope qui se retrouve avec de moins en moins de sens finalement et est-ce que tu peux nous en parler du coup dans la science on commence à avoir

Mathieu CORTEEL (48:12.616)

Mmh.

Pierre Vannier (48:39.736)

arriver, c'est cet effet de bord, j'ai envie de dire finalement.

Mathieu CORTEEL (48:43.432)

Ben oui, alors je pense qu'on va même se percuter avec justement le ras de marée parce que déjà de plus en plus, ça c'est une tendance qu'on a qui précède même les LMS parce qu'on voit depuis, s'il a des papiers qui montent depuis une dizaine d'années, avec divers outils, etc. On a une explosion du nombre d'articles qui sont...

transmis au journaux pour vérification avec peer review et puis surtout une explosion du nombre d'articles qui une fois publiés sont rétractés parce qu'on se rend compte qu'il y a eu justement des données qui étaient falsifiées, il y avait des erreurs dans les hypothèses, des choses qui justement sont un peu étranges et...

Pierre Vannier (49:19.681)

Oui, il y avait ce truc, tu sais, de la matière qui était supraconductive à température ambiante. qu'en fait, on sait qu'il faut que ça soit rapproché du zéro Kelvin et tu eu plein, tu as eu plusieurs fois cette news qui est sortie, mais en fait juste c'était n'importe quoi et ça marchait pas, c'était du délire, etc. pour rebondir sur ce que tu disais.

Mathieu CORTEEL (49:46.066)

Ouais, c'est un peu comme... L'IA nous amène dans un risque aussi justement dans l'utilisation qu'on fait, parce que là, même au niveau de la production scientifique, elle est utilisée massivement, parce qu'évidemment il y a plein de normes, de standards, pour faire sa bibliographie c'est quand même beaucoup plus facile que quand on le faisait à la main avec Zotero, pour vérifier que le point est au bon endroit, la virgule au bon endroit. Évidemment, ça aide à ce genre de choses. Après quand ça rentre dans les contenus, là on a des possibilités.

justement d'hallucinations et d'erreurs qui peuvent passer hors radar et amener à des choses aberrantes. Et moi ça me fait penser à cette série, problème à trois corps où en fait on a des extraterrestres qui débarquent et qui brouillent toutes les données scientifiques, qui foutent en l'air toutes les connaissances. Mais en fait là on est un peu face à ce problème là, ce pas les extraterrestres qui vont débarquer mais c'est avec l'IA qui débarquent en fait dans l'ensemble des activités communautaires et dans l'ensemble des activités de chercheurs.

Parce qu'on nous demande d'aller plus vite, nous demande de produire plus d'articles, les directives du CNRS sont de plus en plus exigeantes à cet égard. Et derrière, fait, on va se retrouver avec justement un problème de problèmes, c'est-à-dire un problème d'une augmentation de la production d'articles et une baisse du niveau de preuve, parce qu'on ne pas tout vérifier humainement. va d'une part...

générer de plus en plus d'éléments par les IA et d'autre part vérifier de plus en plus d'éléments par les IA. Et là, c'est un vrai risque parce que c'est... nous promet la révolution scientifique, le changement de paradigme dans tous les domaines, etc. Moi, justement, ce que je vois plutôt, c'est ce grand risque justement d'une problématisation de contenus générés qui ne peuvent plus être vérifiés parce que c'est l'épée de slope et on est sur une production qui...

qui, du coup, par effet rétroactif, génèrent des hallucinations, des erreurs qui pourront probablement passer hors radar. Il y a tellement d'articles, tellement de revues, tellement de littérature scientifique aujourd'hui, et qui est d'ailleurs en crise, qui est un modèle complètement en crise, parce qu'il faut savoir quand même que quand on fait un peer review d'un papier qu'on nous envoie, on n'est pas payé pour. Et c'est pourtant du travail vraiment minutieux. Regardez les dôtes.

Mathieu CORTEEL (52:04.68)

personne, comment les sources, tout ça, et pour pouvoir s'assurer que ça a une valeur scientifique et personne n'est rémunéré pour ça. Donc en fait on fait ça à côté de notre activité d'enseignement de recherche, on nous demande de vérifier les articles, il y a de plus en plus de gens qui font un premier défrichage avec l'IA, au risque justement de laisser passer des erreurs ou de générer des hallucinations. Et ça c'est un vrai problème épistémologique sur la connaissance aujourd'hui.

Je parlais justement du côté du sens, mais là il y a un vrai problème aussi au niveau du savoir, de la connaissance. Est-ce qu'on n'est pas en train d'arriver à un moment où on est en train de de rendre fallacieuse la production scientifique ? Au point de plus la discerner justement.

Pierre Vannier (52:49.325)

Tu as vu Mathieu récemment, il 3-4 jours, pour rebondir sur ce thème spécifique, a un gars qui est mathématicien, qui a résolu un des problèmes d'air d'euche.

Tu sais qu'il ce mathématicien Erdösch, est un grand mathématicien du milieu du XXe siècle, ne plus si c'est des bulgares ou rhumains, qui a fait aussi à la limite entre les maths discrètes et l'informatique une sommité, il a laissé à la postérité tout un tas de problèmes mathématiques ouverts dont on n'a pas les solutions. Et l'IA, en l'occurrence GPT 5.2, a résolu l'un des problèmes ouverts d'Erdösch.

Et Terence Tao, est une sommité mondiale des mathématiques, considérée comme le Einstein des mathématiques modernes, a validé la démonstration faite par GPT 5.2. Donc, ça pose quand même aussi une question. C'est-à-dire qu'on ne pas jeter toute l'IA en disant qu'elle crée des signes qui sont complètement vides de sens, puisqu'en fait là on vient de donner

parce qu'une démonstration mathématique, c'est donner du sens, on est d'accord ? On vient de donner du sens via l'IA à un problème ouvert que les humains n'arrivaient pas à résoudre. Donc finalement, est-ce qu'on est au bout de la question ?

Mathieu CORTEEL (54:08.808)

Là, c'est intéressant parce que d'une certaine manière, voit que, encore une fois, si on veut parler de sens, ce qui a permis derrière de dire que le théorème est résolu ou pas, ça a été justement une validation, une vérification par les pairs. Là, que je veux dire, l'association, l'hybridation humaine, il y a dans sens-là où on est sur quelque chose du coup d'auto-poïétique, on crée quelque chose en plus, on fait émerger une nouvelle idée, c'est justement ce qu'il faut viser.

Là où il a un problème, c'est où par exemple on aurait une IA qui produit une démonstration et puis une autre qui va vérifier. Et puis nous entre deux qui avons prompté et envoyé les éléments. Si c'est ça notre rôle, effectivement là on est dans de la logo-projétique et on a perdu complètement tout le sens. On peut pas vérifier, etc. Et c'est là où en fait c'est compliqué de trouver un bon agencement. Parce que effectivement, d'un côté je pense que c'est un outil... Ouais c'est ça, mais en fait... C'est ça parce que...

Pierre Vannier (54:59.279)

Tout est question de la place de l'humain en Quelle place on met à l'humain là-dedans en fait, encore ?

Mathieu CORTEEL (55:05.249)

Encore une fois, moi je suis fasciné par cet outil-là. Je trouve qu'il plein de choses hyper intéressantes à faire, en écrit, il y a plein d'éléments qui peuvent émerger, de nouvelles formes.

Pierre Vannier (55:14.337)

Mais il y a des zones dangereuses quand on délègue vraiment complètement ses capacités auditives et de jugement.

Mathieu CORTEEL (55:19.393)

C'est ça, c'est la part de combinatoire qu'on délègue sur notre jugement, sur la signification de nos actions, de nos décisions, sur notre travail intellectuel ou quotidien, sur nos interactions. C'est là où il faut avoir une jugement éclairée pour trouver les bons agencements. D'une certaine manière, effectivement, on va pas...

De toute manière, pense qu'on ne pourra pas faire l'économie de l'IA aujourd'hui, vu l'impact que ça a, la dimension que ça prend dans tous les domaines et tous les secteurs. Néanmoins, on a peut-être des espérances disproportionnelles dans plein de domaines. Moi, pense, par exemple, niveau médical, on a quand même eu ces discours aberrants, transhumanistes, etc., quand on arrivait à tout solutionner avec l'IA, ce qui est complètement faux. voit les applications concrètes. On a des résultats sur des papiers.

Par exemple, va avoir une IA qui reconnaît très bien telle lésion, je sais pas, sur les radios, ou en dermatologie, les mélanomes, etc. Quand on la met dans un service, on n'a pas le même résultat. Pourquoi ? Parce qu'en fait, en contexte, dans une situation concrète, avec la complexité du terrain, avec l'ensemble des acteurs et tout ça, il a des variations qu'on ne mesure pas, en fait, dans l'évaluation avec les benchmarks qu'on s'est donné pour évaluer l'IA. Et c'est là, en fait, où il a une forme de réalisme et de pragmatisme à avoir.

C'est-à-dire, oui, effectivement, c'est des outils qui marchent très bien, en un certain sens, avec du point de vue algorithmique, mais dès lors qu'on les plonge dans le monde humain, les résultats, il y a de l'imprévisible, il a du hasard, il a un ensemble d'éléments qui parasitent, de l'anthropie, qui font qu'on n'arrive pas forcément à ce qu'on veut. Donc, en fait, là, on est au moment où on a des outils qui sont plus ou moins stabilisés, mais qui sont arrivés à un niveau de développement qui est quand même assez avancé. Mais la question maintenant, c'est comment on s'agence avec, comment on les implément de manière...

raisonnable dans les organisations, comment on fait société avec l'IAS, sans justement, évitant le piège de la réinatio, et en participant justement d'une co-construction qui va vers l'émancipation et qui amènera peut-être à des découvertes fantastiques, mais voilà, je veux dire, le microscope, ça nous a fait des découvertes fantastiques, et il a sans doute, nous fera aussi faire des découvertes fantastiques comme d'autres outils. Mais voilà, c'est quelle part on délègue et quelle part on préserve du jugement humain. Et là, il y a tout un enjeu et c'est en fait des questions ouvertes parce que là, on n'a pas...

Mathieu CORTEEL (57:44.934)

encore les outils d'évaluation. c'est ça que je sais de réfléchir, par exemple, au niveau de la médecine, c'est comment on arrive à évaluer les agencements, l'implémentation des idées dans les services dédiés. Effectivement, d'un hôpital d'un contexte à un autre, il y a plein d'éléments différents, y a toute une sociologie à construire, une réflexion à mener là-dessus. Mais je pense que justement, il y a des possibilités d'émancipation si on évite le piège justement de la loi poétique.

et de la vastalisation vis-à-vis des géants de la tech et de leurs perspectives économiques et politiques qui, à mon sens, sont des plus détestables et sur lesquels il faut vraiment devoir s'affronter.

Thomas (58:26.673)

Et justement c'est parfait pour... bah vas-y. C'est ton moment Pierre. Non, c'est ton moment Pierre.

Pierre Vannier (58:26.941)

Écoute, c'est... Ouais... Ben, vas-y.

Non, c'était toi qui devais y aller. Ben vas-y.

Thomas (58:34.441)

Bon, non mais en fait je trouvais que c'était un excellent point de conclusion. Justement Mathieu, on a toujours une question pour le prochain invité, on sait pas qui c'est, ce que ça peut être, peut-être un jour ça sera une intelligence artificielle, mais est-ce tu as une question pour la prochaine personne ? Chose t'y arrive !

Mathieu CORTEEL (58:50.416)

Ok alors attend, un truc un peu drôle.

Thomas (59:00.073)

Bon courage encore une fois.

Pierre Vannier (59:00.333)

génial j'adore j'adore on la garde celle là elle est très très bien bientôt tu sais on aura plus des blagues à Toto etc ou des blagues carambar ce sera les blagues à Claude ou les blagues à ChatGPT bon bah écoutez c'était passionnant Mathieu on aurait pu rester encore vraiment très très longtemps pour vous donner la petite info la petite nuggets en anecdote on est resté une heure et demie avec Mathieu pour préparer le podcast

Mathieu CORTEEL (59:04.41)

Oui oui, elle pas facile.

Thomas (59:08.061)

Bon Pierre, je te laisse ton clur.

Mathieu CORTEEL (59:15.75)

est-ce possible ?

Pierre Vannier (59:27.049)

Donc plus une heure de podcast, on aurait pu rester très très longtemps. Comme il le dit, sont des questions ouvertes. Personne n'a encore la réponse. Tout ça va trop vite. Mais ça nécessite et j'aime quand des chercheurs prennent le temps de se poser et d'avoir ce regard critique sur tout ça pour, ben voilà, pour pour avancer sereinement dans ces nouveaux agencements. Merci beaucoup, Mathieu. Merci Thomas et merci vous qui nous écoutez. À bientôt.

Mathieu CORTEEL (59:50.418)

Merci beaucoup.

Thomas (59:51.747)

Merci à vous, salut !

Mathieu CORTEEL (59:53.638)

Salut !

Pierre Vannier (59:55.277)

Bon ben top ! Très simple

Thomas (59:56.553)

cool

Mathieu CORTEEL (59:56.807)

C'est pas vrai.

Créateurs et invités